L’essor de l’intelligence artificielle a transformé le paysage du contenu en ligne, permettant aux utilisateurs de créer des vidéos toujours plus captivantes et sophistiquées. Mais cette révolution technologique a aussi donné naissance à des pratiques douteuses, voire moralement discutables.

En seulement quelques semaines, un utilisateur du réseau social Tiktok a gagné plus de 150 000 abonnés et ses vidéos ont été visionnées des millions de fois par les utilisateurs de la plateforme.

Sa recette magique pour percer ? Il génère des vidéos avec l’intelligence artificielle où on peut voir des enfants morts ou disparus parler de vive voix.

On n’arrête pas le progrès…

À lire aussi :

Des millions de chats errants vont être éradiqués à l’aide de robots intelligents

Réaliser un deepfake est de plus en plus facile avec l’IA

Les deepfakes sont des vidéos ou des images synthétiques créées grâce à l’intelligence artificielle. Ils sont utilisés pour créer des vidéos drôles, mais également pour créer du contenu trompeur qui a pour but de manipuler des personnes.

A une époque, cela demandait des compétences particulières, mais aujourd’hui, c’est un jeu d’enfant et ça ne demande aucune connaissance technique.

Il suffit de générer l’image avec Midjourney, puis ensuite d’aller sur https://www.d-id.com/ pour faire parler une personne fictive ou bien réelle.

Temps approximatif pour la réalisation de la vidéo ? Seulement quelques minutes…

Si il peut être assez drôle d’utiliser ces différents services pour créer du contenu humoristique, certains n’hésitent pas à utiliser ces outils technologiques pour publier des vidéos nauséabondes.

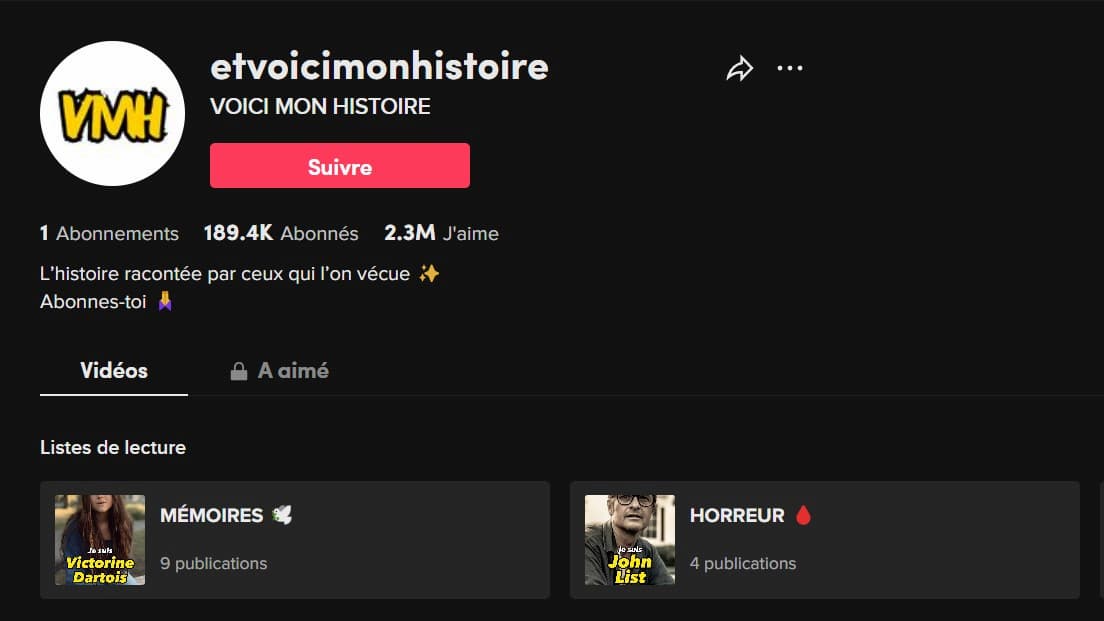

C’est le cas du Tiktokeur @etvoicimonhistoire, qui a publié une dizaine de vidéos sur son compte et qui a récolté de nombreux likes.

Dans celles-ci, on peut voir apparaître Gregory Villemin, Estelle Mouzin et bien d’autres enfants qui ont été tués ou qui ont totalement disparu du jour au lendemain.

https://www.tiktok.com/@etvoicimonhistoire/video/7225996145011477786

À lire aussi :

ChatGPT 4 : Découvrez les nouvelles fonctionnalités incroyables de l’IA

Vous avez eu la gerbe en regardant cette vidéo ? Si la réponse est oui, félicitation ! Vous avez encore un semblant d’humanité…

« Ca m’inspire du dégout et du mépris »

Cette déclaration n’est pas la mienne, mais celle du père d’Estelle Mouzin, jeune fille disparue en 2003.

Interrogé par un journaliste de BFM TV au sujet de cette mode qui consiste à faire « revivre les morts » sur Tiktok, il a déclaré :

« Je n’ai pas envie de commenter ce genre de vidéos, si on peut appeler ça une vidéo, car ce serait apporter du crédit à quelque chose qui n’inspire que du mépris et du dégoût. »

Du côté de la justice, Didier Seban, l’avocat du père d’Estelle Mouzon a spécifié qu’il allait entreprendre des démarches auprès des plateformes pour demander le retrait des vidéos qu’il considère « odieuses et particulièrement inquiétantes ».

L’homme de droit estime que ces contenus portent atteinte à la dignité des morts.

Vers une interdiction des contenus générés par l’intelligence artificielle sur Tiktok ?

Devant la grande quantité de vidéos générées par l’IA où on peut voir des personnalités telles que Barack Obama, Emmanuel Macron et bien d’autres, TikTok a décidé de siffler la fin de la récréation.

En effet, le média social a mis à jour ses règles communautaires afin de réguler les contenus générés par l’IA.

Est-ce que cela sera suffisant ?

À lire aussi :

Lemon8 : Le nouveau réseau social « Lifestyle » lancé par Tiktok

J’en doute, puisque sur la page d’accueil de l’application Tiktok, je vois encore beaucoup de vidéos de ce genre…